Sozio-technische Systeme

Stellen wir uns das Jahr 1991 vor: Der Informatiker Mark Weiser entwirft eine Vision, die ihrer Zeit weit voraus ist. Er spricht von einer Zukunft, in der Computer nicht mehr als Bildschirme und Tastaturen in Erscheinung treten, sondern im Hintergrund verschwinden. Sie verstecken sich in Alltagsgegenständen, verschmelzen mit unserem Leben, bis wir sie kaum noch bemerken. „Die tiefgreifendsten Technologien sind jene, die aus unserer Wahrnehmung verschwinden“, sagt Weiser damals. Er nennt diese Zukunft Ubiquitous Computing – allgegenwärtige Datenverarbeitung, unsichtbar eingewoben in das Gewebe des Alltags.

Vom Script zur Selbstständigkeit

Dreißig Jahre später ist diese Vision Realität geworden – und wir gehen längst darüber hinaus. IT-Automatisierung bildet das Rückgrat dieser unsichtbaren Maschinenwelt. Was früher mühselig von Hand geschah, erledigen heute Skripte, Software und standardisierte Abläufe: Netzwerke werden orchestriert, Clouds konfiguriert, Systeme überwacht. Fehler sinken, Kosten ebenso – Verfügbarkeit steigt. Doch je mehr wir automatisieren, desto mehr beginnen Systeme, sich selbst zu steuern.

Wenn Maschinen lernen

Die nächste Stufe: Künstliche Intelligenz. Plattformen, die nicht nur Routineaufgaben übernehmen, sondern Muster erkennen, Prozesse priorisieren und neue Zusammenhänge aufdecken. Systeme werden lernfähig. Routine wird zum Lernprozess, Reaktion zur Echtzeit-Entscheidung. Wir erleben, wie Technik elastisch wird – anpassungsfähig an den Moment.

Alles in Echtzeit

Ein freier Parkplatz, gemeldet in einer App. Ein medizinischer Sensor, der sofort Alarm schlägt. Ein Markt, der in Sekunden auf Daten reagiert. Echtzeitdaten verändern, wie wir handeln. Sie fließen zurück in die Systeme, werden mit Kontext angereichert, verbessern das Ganze. Damit entsteht ein Kreislauf, der Verkehr, Gesundheit, Handel, Politik – ja, fast jede Lebenssphäre – durchdringt.

Sozio-technische Netze

Doch diese Systeme sind mehr als Technik. Sie sind sozio-technische Gebilde: Supermarktkassen, Online-Shops, Gesundheitsplattformen – sie alle verbinden Mensch und Maschine. Dabei sind sie alles andere als neutral. Ihr Design entscheidet darüber, wer teilhaben kann, wie gerecht Interaktionen sind und welche Grundrechte gewahrt bleiben. Deshalb wird Gestaltung selbst zu einer politischen Aufgabe.

Automatisierte Entscheidungen

Sobald Systeme personenbezogene Daten verarbeiten, wird es ernst. Dann greift die DSGVO. Besonders heikel: automatisiertes Profiling. Wer erhält einen Kredit, eine Versicherung – oder einen Job? Solche Entscheidungen können lebensentscheidend sein und in der Regulierung sucht man nach Wegen, letztlich Menschen die Verantwortung für die Entscheidung zu übertragen, wenn erhebliche rechtliche Folgen im Spiel sind.

Die Grenze heißt Risiko

Hier setzt der europäische AI-Act an: Er unterscheidet zwischen geringem und hohem Risiko. Praktiken wie Dark Patterns oder Social Scoring sind schlicht verboten. Große KI-Modelle können in sensiblen Kontexten als Hochrisiko-Systeme gelten, wenn sie in sensiblen, regulierten Anwendungsbereichen eingesetzt werden, eine erhebliche Wirkung auf Menschen, Gesundheit und bestimmte Rechte haben, und wenn sie bestimmte Funktionen erfüllen, bei denen der Gesetzgeber besondere Risiken sieht.

Die Botschaft ist klar: Je höher das Risiko für Menschen und Gesellschaft, desto strenger die Regeln.

Wer kontrolliert wen?

„Privacy by Design“ soll Datenschutz schon ins System einbauen. Doch Technik entwickelt oft eine Eigendynamik, die kaum noch steuerbar ist. Fehler lassen sich nicht einfach zurückdrehen. Menschen passen sich an Systeme an – statt umgekehrt. Deshalb stellt sich die eigentliche Frage: Wer hat die Kontrolle über das Design? Wer legt fest, welche Werte in Algorithmen einfließen?

Wohin wir unterwegs sind

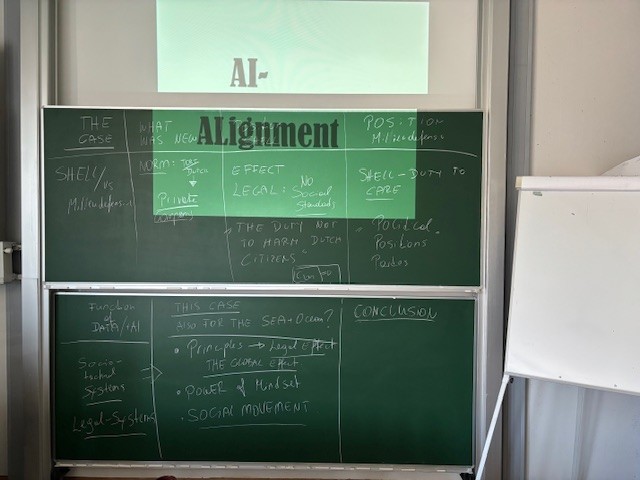

Schon Isaac Asimov ahnte 1950, dass wir Regeln brauchen, wenn Maschinen „Entscheidungen treffen“.

Die drei Robotergesetze von Isaac Asimov wurden erstmals 1942 in seiner Kurzgeschichte „Runaround“ veröffentlicht, die in der Sammlung I, Robot (1950) erschien. Sie wurden später in Asimovs Werk weiterentwickelt und sind ein zentrales Element seiner Robotergeschichten.

Asimovs Robotergesetze sollen Maschinen sicher und moralisch handeln lassen und stehen in engem Zusammenhang mit dem Konzept des AI-Alignments, also der Ausrichtung künstlicher Intelligenz an menschlichen Werten.

Einige Jahre nach der Einführung der ursprünglichen drei Gesetze fügte Asimov ein viertes Gesetz hinzu, das als „Nulltes Gesetz“ bekannt wurde. Dieses Gesetz wurde erstmals 1958 in der Kurzgeschichte „The Evitable Conflict“ erwähnt und später in Foundation and Earth (1986) weiter ausgeführt.

Die Robotergesetze sind ein literarisches Konzept und keine realen Vorschriften. Sie wurden von Asimov entwickelt, um ethische und philosophische Fragen im Zusammenhang mit künstlicher Intelligenz und Robotik zu untersuchen. In seinen Geschichten zeigt Asimov, wie Roboter durch die Anwendung dieser Gesetze in komplexe moralische Dilemmata geraten können.

Im Hörsaal.

Kurze Darstellung der Robotergesetze:

- Erstes Gesetz (Schutz des Menschen):

Ein Roboter darf keinen Menschen verletzen oder durch Untätigkeit zulassen, dass einem Menschen Schaden zugefügt wird.

Literarische Bedeutung: Dieses Gesetz stellt sicher, dass Roboter in Asimovs Geschichten in erster Linie dem Schutz der Menschheit dienen. Es ist ein erzählerisches Mittel, um Konflikte zwischen Mensch und Maschine zu untersuchen. - Zweites Gesetz (Gehorsam gegenüber Menschen):

Ein Roboter muss den Befehlen von Menschen gehorchen, solange diese nicht dem ersten Gesetz widersprechen.

Literarische Bedeutung: Dieses Gesetz zeigt, wie Roboter mit Autorität umgehen, und schafft moralische Dilemmata, wenn Befehle im Widerspruch zum Schutz von Menschen stehen. - Drittes Gesetz (Selbsterhaltung):

Ein Roboter muss seine eigene Existenz schützen, solange dies nicht dem ersten oder zweiten Gesetz widerspricht.

Literarische Bedeutung: Dies erlaubt Asimov, die Logik und Selbstwahrnehmung von Robotern zu erforschen, ohne dass sie unbesiegbar oder unfehlbar sind. - Nulltes Gesetz (später hinzugefügt):

Ein Roboter darf der Menschheit keinen Schaden zufügen oder durch Untätigkeit zulassen, dass die Menschheit Schaden nimmt.

Literarische Bedeutung: Dieses Gesetz erweitert die Perspektive auf die gesamte Menschheit und erlaubt komplexe ethische Konflikte in Asimovs späteren Geschichten. Es zeigt, dass das Wohl der Menschheit manchmal Vorrang vor dem Einzelnen haben könnte.

Beitragsbild und Fotos: Elisabeth Hödl