Human in the Loop: SF & KI-VO

Science-Fiction war immer ein Labor für gesellschaftliche Zukunftsfragen. Lange bevor die KI-VO über „menschenzentrierte Kontrolle“ sprach, entwarf man in der Science Fiction Szenarien, in denen Mensch und künstliche Intelligenz zusammenwirken – manchmal produktiv, manchmal auf eine Weise, die gefährlich ist.

Was bedeutet „Human in the Loop“?

„Human in the Loop“ (HITL) beschreibt ein System, in dem KI nicht autonom „agiert“, sondern durch menschliche Aufsicht, Eingriffe und Entscheidungen ergänzt wird. Der Mensch bleibt sohin Teil des Entscheidungsprozesses – als Kontrollinstanz, als moralischer Filter und Korrektiv.

Im Unterschied dazu stehen:

• Human on the Loop – der Mensch überwacht, greift aber selten ein.

• Human out of the Loop – die KI entscheidet weitgehend autonom.

Human in the Loop ist das Modell, das die EU Verordnung über künstliche Intelligenz (in Folge: KI-VO) für risikoreiche Anwendungen vorschreibt: Menschen müssen KI-Entscheidungen verstehen und verantworten. (Vgl Art 14 KI-VO, Menschliche Aufsicht).

Human in the Loop ist nicht bloß ein technischer Begriff, sondern ein tiefes kulturelles Motiv. Dies zeigt sich in einigen SF-Szenarien, in denen auch jene Fragen verhandelt werden, die heute in Regulierungsfragen und im Haftungsrecht relevant werden. Es sind Fragen des Kontrollverlusts, der Delegation, der moralischen Letztentscheidung und der Governance.

In den folgenden fünf Werken der Science-Fiction-Literatur zeigt sich dies in unterschiedlichen Facetten:

1. Neuromancer – William Gibson (1984): Der Mensch als notwendige Komponente eines KI-Ziels

Die KI Wintermute in Gibsons Roman ist hochintelligent, aber nicht autonom. Sie ist an Beschränkungen gebunden und braucht Menschen (vor allem den Hacker Case und die Straßensamurai Molly) um das zu tun, was sie selbst nicht darf oder kann. Wintermute erzeugt Visionen, manipuliert Wahrnehmungen, plant Strategien. Aber: Wintermute kann die physische Welt nicht direkt beeinflussen.

Rechtlicher Bezug:

Das entspricht heutigen Debatten über Autonomiegrenzen in der KI-VO. Eine KI dieser Art wäre wohl als „Hochrisiko-System“ einzustufen und an menschliche Aufsicht gebunden. Gibson zeigt zudem ein Kernproblem auf: Die Menschen wissen nicht, dass sie ein KI-System bedienen. Genau dieses Transparenzdefizit adressiert die KI-VO heute. Wenn Menschen Teil des Systems sind, aber manipuliert werden, bleibt Verantwortlichkeit unklar und es entsteht ein Risiko, das Regulierung durch Aufsichtspflichten und Governance mindern soll.

2. The Moon Is a Harsh Mistress – Robert A. Heinlein (1966): Die kollektive Entscheidungsinstanz

Die KI Mike ist ein superintelligenter Rechner, der eine Mondkolonie bei ihrer Rebellion unterstützt. Mike analysiert, berechnet Wahrscheinlichkeiten und Risiken und erstellt Strategien. Er ist rationaler, objektiver und schneller als Menschen, aber politische Entscheidungen (etwa ob die Kolonie nun rebelliert oder nicht) treffen die Menschen selbst. Die KI Mike arbeitet sohin als beratende KI – sie ist überaus leistungsstark, aber eben nicht entscheidungsbefugt. Die KI erweitert die Kapapazitäten der Menschen, ohne sie zu ersetzen.

Rechtlicher Bezug:

Dieses Szenario entspricht dem Themenfeld der assistiven KI, wie sie die KI-VO vorsieht: Unterstützung ja, autonome Entscheidung nein. Heinlein antizipiert hier ein Prinzip moderner Regulierung: Menschliche Letztentscheidung ist Pflicht. Zudem wirft das Buch die Frage der Haftung bei gemeinsamer Entscheidungsfindung auf: Wenn Mike eine Strategie empfiehlt, die gefährlich ist, aber Menschen sie umsetzen – wer trägt dann die Verantwortung? Im EU-Kontext würde man fragen: Sind nun die menschlichen Entscheider und Betreiber verantwortlich, da die KI nicht autonom handelt?

3. Diaspora – Greg Egan (1997): Entscheidungen in vollständig integrierten Mensch-KI-Systemen

Egan beschreibt post-biologische Menschen, deren Bewusstsein digital existiert. Sie arbeiten eng mit hochentwickelten KI-Entitäten zusammen. Entscheidungen entstehen nicht durch „Mensch gegen Maschine“, sondern in symbiotischen Prozessen. Die Grenzen zwischen künstlicher und menschlicher Intelligenz verschwimmen, aber ein menschlicher Kern bleibt: Kreativität, Neugier und moralisches Empfinden. Die KI aber liefert Präzision, Simulation und Komplexitätsbewältigung.

Rechtlicher Bezug:

Egan skizziert die juristisch brisante Frage: Wenn Mensch und KI verschmelzen, wer ist dann verantwortlich? Die KI-VO verlangt klare Zurechenbarkeit; eine identifizierbare menschliche Instanz, die Entscheidungen prüft und legitimiert. Diese aber existiert in diesem Szenario nicht mehr, denn wir haben es mit einem System kollektiver Intellegenz zu tun. Was erkennen wir? Finden sich in integrierten Systemen keine identifizierbaren menschliche Instanzen – entsteht ein Verantwortungsvakuum.

4. Ghost in the Shell (ab 1989): Überwachung der KI durch den erweiterten Menschen

Cyborg-Agentin Motoko Kusanagi interagiert direkt mit Netz-KIs; Informationen fließen in Echtzeit in ihr Gehirn. Sie kann maschinelle Intelligenz anzapfen und zugleich moralische Entscheidungen treffen – etwas, was die KI in diesem Setting nicht darf. Der Mensch ist in the Loop und gleichzeitig technisch erweitert – aber weiterhin das moralische Zentrum. Die Gefahren liegen in der Manipulation von Wahrnehmung, unklarer Identität und im Verlust der Autonomie.

Rechtlicher Bezug:

Diese Szenarien entsprechen den heutigen Debatten zu:

• KI-Assistenz in sicherheitskritischen Bereichen

• biometrischen Systemen

• autonomen Waffensystemen

• Echtzeit-ÜberwachungDie KI-VO würde solche Systeme wohl ebenfalls als Hochrisiko-Anwendungen mit den verlangten strengen Kontrollen sehen. Ghost in the Shell zeigt was passiert, wenn Kontrolle schwindet und Human in the Loop wird zur Schwachstelle, der Mensch selbst zum Angriffspunkt.

5. Excession – Iain M. Banks (1996): Moralische Letztentscheidung trotz überlegener KI

Die „Minds“ sind gewaltige leistungsstarke KI-Schiffe, die taktische, logistische und strategische Aufgaben auf einem Niveau erfüllen, das menschliche Fähigkeiten weit übersteigt. Sie sind von enormer Rechen- und Planungskapazität und arbeiten mit menschlichen Crewmitgliedern zusammen. Die Menschen liefern zwar nicht die beste Berechnung, aber ihre Rolle besteht in der ethisch-moralischen Orientierung.

Rechtlicher Bezug:

Was wir hier sehen, ist fast eine literarische Illustration dessen, was in der KI-VO normiert wird: KI optimiert, aber die Zweckbestimmung bleibt beim Menschen. Banks wirft aber die entscheidende Frage auf: Wie sinnvoll kann menschliche Kontrolle sein, wenn KI viel mehr versteht als der Mensch? Im Recht spricht man von „effective human oversight“, Erklärbarkeit und Auditierbarkeit. Selbst überlegene KI darf nicht zum moralischen Entscheider werden. Governance muss sicherstellen, dass Menschen, die Richtung bestimmen – unabhängig davon, wie schnell oder klug ein System ist.

So frage wir uns: Können Menschen tatsächlich die Kontrolle behalten?

Die juristische Grundidee ist klar: Der Mensch soll die letzte Instanz der Entscheidung bleiben. Doch genau an diesem Punkt beginnt das Paradox des Human-in-the-Loop-Ansatzes. Menschen sind verantwortungsfähig – aber sie sind eben auch fehlbar. Sie entscheiden unter Druck, aus Eigeninteresse, aus Angst oder Gewohnheit. Sie sind manipulierbar, durch Technologie wie durch andere Menschen.

Kann eine Spezies, die selbst von Impulsen und Emotionen geprägt ist, dauerhaft als Kontrollinstanz über zunehmend komplexer werdenede KI-Systeme fungieren?

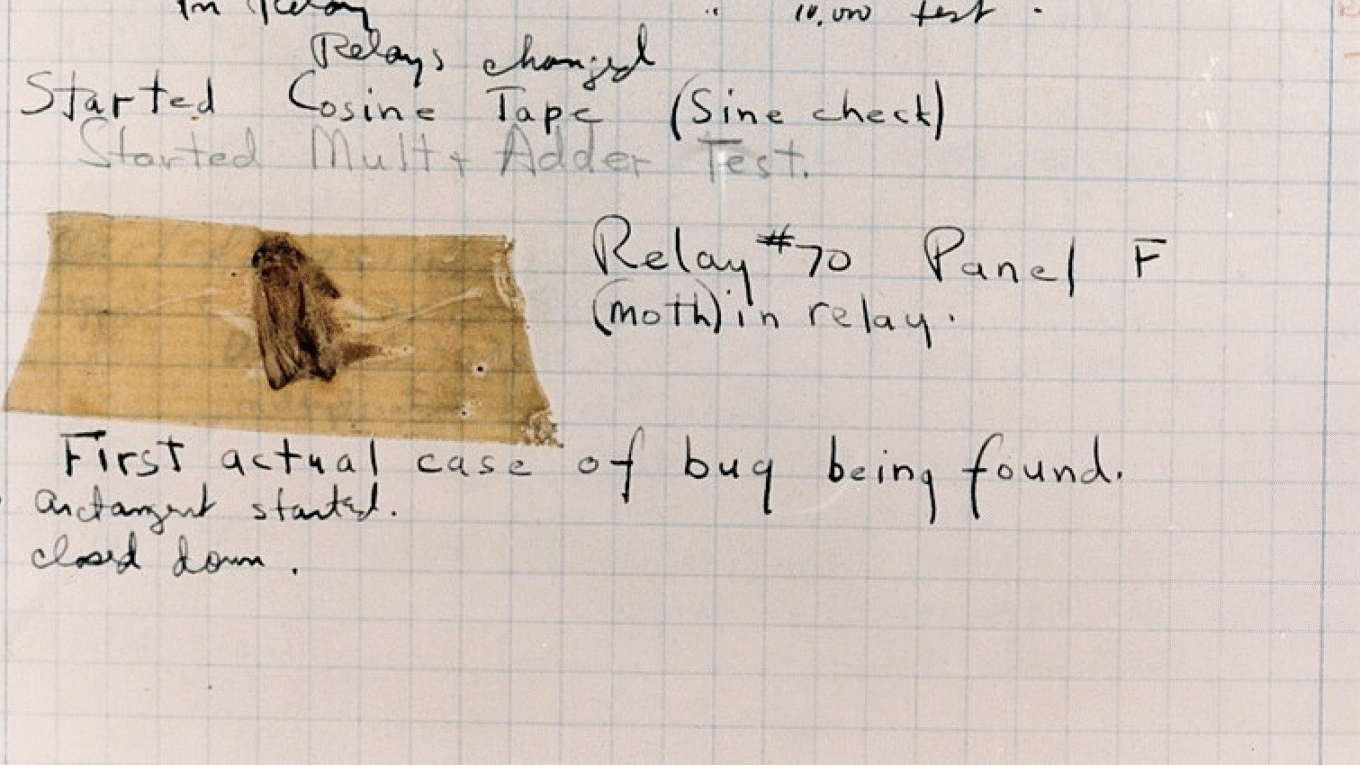

Abb: Hum – Bug (The Public Domain).

Dieser Beitrag wurde erstellt in einem Human in the Loop Prozess, in dem KI die Rolle einer kritischen Instanz spielte. Das Beitragsbild zeigt den ersten Computer Bug der Geschichte, 1945 im Harvard Mark II computer; siehe dazu auch Grace Hopper. Urheber des Fotos: Courtesy of the Naval Surface Warfare Center, Dahlgren, VA., 1988 – gemeinfrei.